本文轉自【工信部反詐專班】;

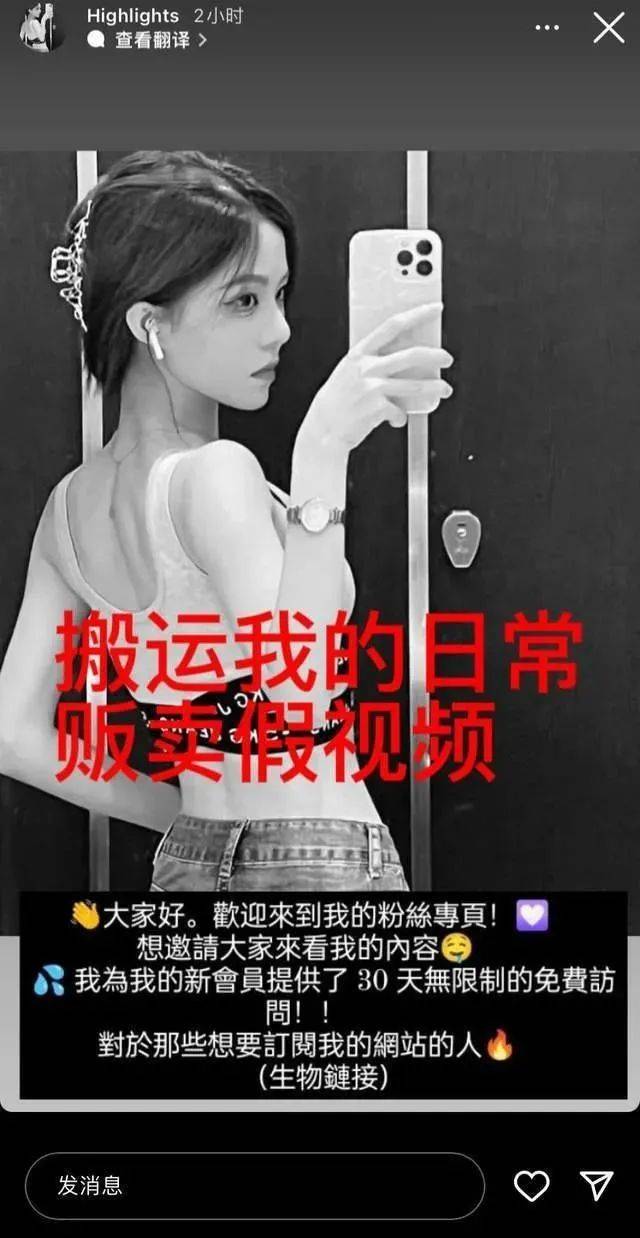

近日,一名擁有百萬粉絲的女網紅爆出了一起“AI換臉”事件。這名女網紅表示,她的視頻評論區突然涌來了很多人說看過她的“視頻”,但她從未發布過這樣的視頻。

她疑惑地點開了這個視頻,結果發現里面的女生和她長得一模一樣,但做著一些難以描述的動作,讓她感到非常憤怒和無助。她隨即意識到可能是她的臉被人工智能(AI)盜用了。

AI技術發展迅速,最近爆火的AI換臉,大家不知道玩過沒有。

只需要提供一張帶臉的照片,就可以把自己置換成視頻、電視劇中的男(女)主角,而且擬真度非常高,毫無違和感。

有人把鹿晗的臉置換到劉亦菲扮演的“小龍女”角色中,就是下面這個效果。如果不是事先看過《神雕俠侶》,還以為就是本人呢。

AI詐騙常用手法

第一種: 聲音合成

騙子通過騷擾電話錄音等來提取某人聲音,獲取素材后進行聲音合成,從而可以用偽造的聲音騙過對方。

案例

某公司財務小王接到領導電話,要求立刻給供應商轉款2萬元,并將轉賬信息以郵件形式發送,轉款理由是避免繳納滯納金。由于老板的口音十分逼真,小王信以為真,在1小時內轉款完成,后發現被騙。

第二種:AI換臉

人臉效果更易取得對方信任,騙子用AI技術換臉,可以偽裝成任何人,再通過視頻方式進行信息確認,真是防不勝防!

騙子首先分析公眾發布在網上的各類信息,根據所要實施的騙術,通過AI技術篩選目標人群。在視頻通話中利用AI換臉,騙取信任。

案例

近日,小李的大學同學通過QQ跟她借錢。對方打過來一段四五秒的視頻電話,小李看到確實是本人,便放心轉賬3000元。然而,她在第二次轉賬時感覺異常,便再次撥通對方電話,這才得知同學的賬號被盜,遂報案。警方判斷,那段視頻很有可能是被人換了臉。

第三種:轉發微信語音

微信語音居然也能轉發,這操作簡直了!騙子在盜取微信號后,便向其好友“借錢”,為取得對方的信任,他們會轉發之前的語音,進而騙取錢款。

盡管微信沒有語音轉發功能,但他們通過提取語音文件或安裝非官方版本(插件),實現語音轉發。

第四種:通過AI技術篩選受騙人群

騙子不是漫無目的地全面撒網,而是別有用心地鎖定特定對象。他們會根據所要實施的騙術對人群進行篩選,從而選出目標對象。

舉個例子:當進行金融詐騙時,經常搜集投資信息的小伙伴會成為他們潛在的目標。

運用AI技術,再加上套路和劇本的演繹,這樣的詐騙手段,小伙伴們能hold住嗎?

如何防范?

HOME

面對利用AI人工智能等新型手段的詐騙,我們要牢記以下幾點:

多重驗證,確認身份

01

在涉及到轉賬交易等行為時,小伙伴們要格外留意,可以通過電話、視頻等方式確認對方是否是本人。

在無法確認對方身份時,可以將到賬時間設定為“2小時到賬”或者“24小時到賬”,以預留處理時間。盡量通過電話詢問具體信息,確認對方是否為本人。

即便對方運用AI技術行騙,也可以通過提問的方式進一步確認身份。建議大家最好向對方的銀行賬戶轉賬,避免通過微信等社交軟件轉賬。一方面有利于核實對方身份,另一方面也有助于跟進轉賬信息。

保護信息,避免誘惑

02

加強個人信息保護意識,小伙伴們要謹防各種信息泄露,不管是在互聯網上還是社交軟件上,盡量避免過多地暴露自己的信息。

對于不明平臺發來的廣告、中獎、交友等鏈接提高警惕,不隨意填寫個人信息,以免被騙子“精準圍獵”。

相互提示,共同預防

03

這些高科技手段的詐騙方式,迷惑了很多小伙伴。警察蜀黎也提示各位要多多提醒、告誡身邊的親人、朋友提高安全意識和應對高科技詐騙的能力,共同預防受騙。

做好家中老人的宣傳防范工作。提醒老年人在接到電話、短信時,要放下電話,再次撥打家人電話確認,不要貿然轉賬。

拒絕誘惑,提高警惕

04

小伙伴們要學會拒絕誘惑,提高警惕。避免占便宜心理,警惕陌生人無端“獻殷勤”。

如果事先不知道騙子的這些伎倆,被騙的可能性非常大。還是那句話:

你目前還沒被騙,并不是因為你多聰明,也不是因為你沒錢,而是適合你的“劇本”還在路上。